The registration period ends in

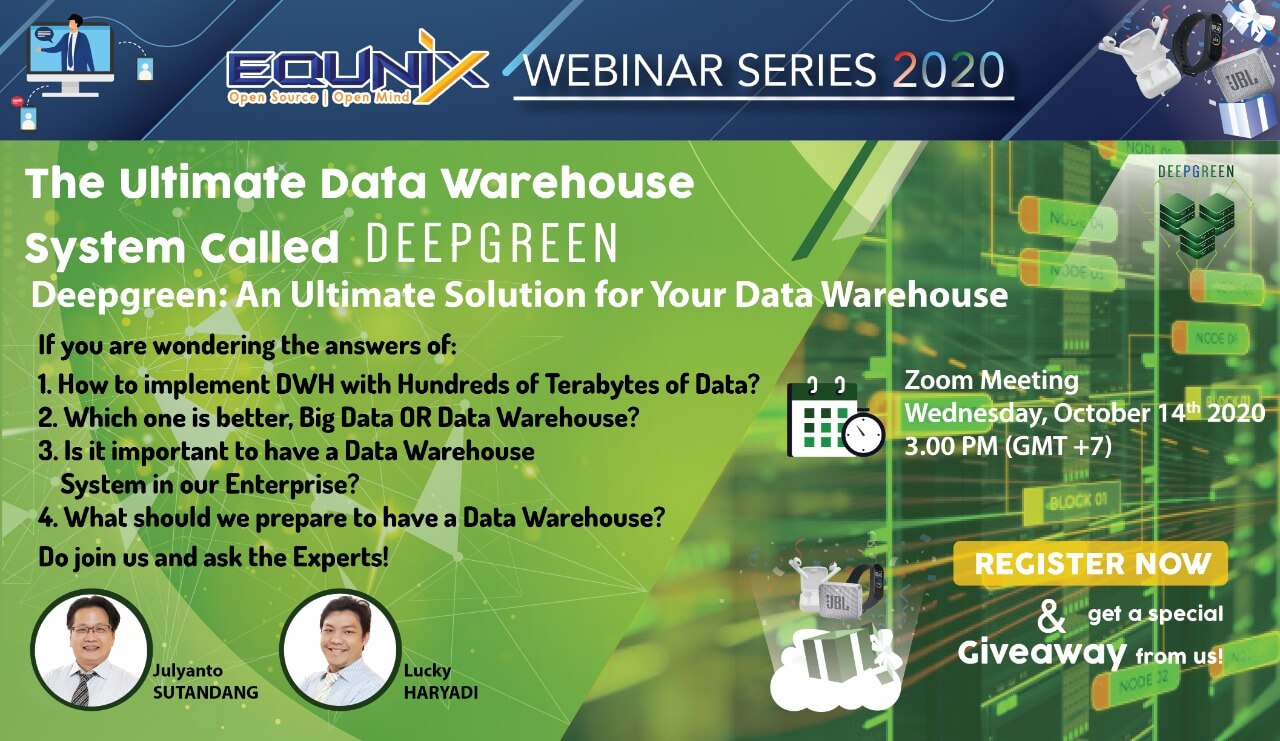

Do join us, ask the Experts, and get a special Giveaway!

Data Warehouse system is increasingly being used by Enterprises in line with the large amount of data they have. The need of having a Data Storage system for decades Data up to Petabytes requires a reliable Data Warehouse system that has high reliability, availability and scalability.

If you are looking for on how to implement and increase the Data Warehouse System, and wondering with the answers of questions below:

-

1

How to implement DWH with Hundreds of Terabytes of Data?

-

2

Which one is better, Big Data OR Data Warehouse?

-

3

Is it important to have a Data Warehouse System in our Enterprise?

-

4

What should we prepare to have a Data Warehouse?